邦内创业者和投资人怎么对于 figure 01 古板人:隔绝具身智能尚有众远?

3 月 13 日,Figure 发布了和 OpenAI 合作后的首个机器人 Figure 01 的演示:视频中,Figure 的人形机器人,可以完全与人类流畅对话,理解人类的意图,同时还能理解人的自然(Nature)语言指令进行(Carry Out)抓取和放置,并解释自己为什么这么做。

Figure 01 具体采用了什么技术,和 Sora 有关吗?

相比过去的机器人技术有什么质的飞跃?以及这对于国内机器人创业者有什么新的启发?

针对以上问题,我们(We)采访了国内大模型和机器人行业的创业者、投资人,以下回答经 Founder Park 整理编辑。

大模型+机器人,OpenAI 又「截胡」了 Google李志飞:出门问问创始人 CEO。原理:Figure 类似 PaLM-E + RT-1,而非端到端的 RT-2原理上,机器人 Figure 看起来类似于 Google 在 2023 年 3 月发布的 PaLM-E 和 RT-1 的 pipeline 组合,而不是Google 于 2023 年 7 月发布的端到端模型 RT-2。

我们(We)知道,如果机器人要与人进行(Carry Out)自然(Nature)语言交互(比如,人说「把桌子上的苹果拿给主人」),可以大致分为以下两个步骤。

一是机器理解自然(Nature)语言,并把自然(Nature)语言转换成机器的抽象计划(所谓 high-level planning),这个抽象的计划可能是一系列的简单自然(Nature)语言指令(比说「拿起苹果」、「把苹果移到人手上方」、「放开苹果」)。

二是把这个抽象计划转换成底层具体的操控(所谓 low-level 执行),既把简单的自然(Nature)语言指令转换成一系列的具体动作(比如旋转、移动、抓取、放开等基本动作)。

简单来说,RT-1 仅是一个能听懂简单指令的机械臂,完成上面说的第二个步骤,模型中没有思维链,也不具备推理能力。PaLM-E 让机器人有了聪明的大脑,可以将复杂自然(Nature)语言指令分解为简单指令,完成上面说的第一个步骤,然后再去调用 RT-1 执行动作。

所以,PaLM-E 所做的只是自然(Nature)语言理解以及 Planning 部分的工作,并不涉及机器人动作本身,它是一个 VLM(Vision-Language Model)模型。

RT-2 则是把以上环节端到端地集成到了一起,它能够用复杂文本指令直接操控机械臂,中间不再需要将其转化成简单指令,通过自然(Nature)语言就可得到最终的 Action,它是一个 VLA(Vision-Language-Action Model)模型。

1

端到端的好处,是通用、能自动适应环境的各种变化,但问题是决策速度慢,很难做到 Figure 这种 200hz 的决策速度,比如 RT-2 论文里提到的决策频率是 1 到 5hz,具体取决于语言模型的参数规模。

亮点:既能用到大语言模型的常识和 COT,又能达到人一般的操控速度Figure 视频的亮点是它既利用(Use)了大语言模型的常识和思维链 COT的能力,又达成了快速的底层操控,几乎接近人的速度。

比如在视频中,当人说「我饿了」,Figure 思考了 2-3 秒后,小心翼翼地伸手抓住苹果,并迅速给人递过来。

因为 Figure 基于大语言模型的常识,明白苹果是它面前唯一可以「吃」的事物,在人类没有任何提示和说明的前提下,即可以接近于人类的反应速度,与人自然(Nature)交互。

另外,也用上了大语言模型的长上下文的理解能力,比如「你能把它们(They)放到那里吗」,谁是「它们(They)」,「那里」是哪里?这些只有大语言模型才有能力精准抓取长上下文里的指代关系。

Figure 是否用到了 Sora?肯定的是,Figure 与 Sora 一点关系都没有,因为 Sora 现阶段主要是生成,不是理解,就算将来 Sora 既能理解也能生成,是否能端到端做到 200hz 的决策速度也是一个很大的问题。

Figure 是否用到了远程操控?有人觉得视频是远程操控(所谓 Teleop)录制的,但 Figure 创始人 Brett Adcock 强调了视频不是 Teleop,录制速度也是 1 倍原速度,所以视频中能看到回答问题的明显延迟(因为语音识别、大语言模型、TTS 是通过 pipeline 方式连起来的,都需要计算时间)。

Figure 是端到端模型吗?Figure 创始人 Brett Adcock 上面这个 Post 提到是端到端的神经网站,个人觉得这可能是口误吧。

从他们(They)技术负责人的 Twitter post 里可以看出,至少用了两个神经网站模型,一是 OpenAI 的 GPT4V(类似于 Google 的 PaLM-E);另外一个是机器人操控的模型(类似于 RT-1)。

所以 Figure 不是类似于 RT-2 的「端到端」模型,而是一个 pipeline 系统。

总结一下

我们(We)可以理解为 Figure 的机器人模型是:GPT4V + 操控模型 ≈ Google 的 PaLM-E + RT-1

再次感叹,OpenAI 的「远见卓识」,在机器人与大模型结合的领域,又让隔壁的 Google 起了大早,赶了晚集。一如既往,OpenAI 超越 Google 的方式不是在技术原理,而是在于产品定义以及宣传方式。比如,与 RT-2 用一个机械臂演示不一样,他们(They)用了一个真实的人形机器人来演示。

此外,他们(They)通过展示机器人的操控速度和自然(Nature)度来吸引观众的眼球。这些都比 Google 那种纯工程师演示的方式倍加有吸引力。

Figure 联合创始人兼首席执行官 Bred Adcock 表示,「我们(We)的目标是训练一个世界模型,以操作十亿单位级别的仿人机器人。」这些机器人,可以消除对不安危和不理想(Ideal)工作的需求,最终让人类拥有更有意义的生活(Life),这也与 OpenAI 的「超级对齐」愿景不谋而合。

计算机是虚拟世界的通用平台,机器人是物理世界的通用平台。

从特斯拉的 Optimus 到今天(Today)的 Figure,将来的模型能力和机器人硬件会如何平衡,从广告噱头到量产应用还有多远?人形机器人百家争鸣的春秋时代已拉开序幕。

李志飞,出门问问创始人兼CEO,米国约翰霍普金斯大学(University)计算机系博士,自然(Nature)语言处理及人工智能教授,前Google总部科学家,祖国大模型创业者,持续探索AGI及商业化落地。

首次向公众呈现了当下具身智能创业的核心方向韩峰涛:千寻 SpiritAI CEO,已投入具身智能行业创业。1、Figure 的宣传视频首次以通俗易懂的方式向公众展示了这一波具身智能创业机会的核心,即 AI 系统自主的以接近自然(Nature)的方式释放机器人硬件的性能。

2、任务理解、拆分和自然(Nature)语言对话属于现有 VLM 能力范围内,动作丝滑远超以往。

3、证明在单一任务内,VLM+具身动作规划模型+遥操微调+RL 路线可行度最高,以及微调数据质量高低对任务动作生成效果有直观影响。

4、精细操作、涉及力交互场景以及 LongHorizon 任务的效果待体坛。

5、强 AI 大脑与好机器人身体执行缺一不可,目前(Currently)国内这样的团队还是偏少。

单点技术的快速发展会带来今年(This Year)机器人的「大突破」陈润泽:源码资本执行董事。基本和我年初的预测一致,2024 年,我们(We)会不断看到机器人领域有一些令人兴奋(Excited)的进展出来,相信 Figure 的 demo 只是其中之一,而且肯定不是其中最具突破性的。

为什么有这个预测?因为机器人整个技术栈里的单点技术都在快速进展,它们(They)排列组合一下就会有一些很具「视觉冲击力」的成果出来。

但是,有必要给看到 Figure 视频过于兴奋(Excited)的人泼点冷水。先说结论:我没有在 Figure 的 demo 中看到非常新的技术能力,目前(Currently) demo 的性质更像是我们(We)去年常说的 GPT-wrapper 的状态。换句话说,要达到这个 demo 的状态并没有很多 secrets。当然这里 wrapper 没有负面的意思,硬件产品需要很好的 wrapper。在这一点上,必须承认 Figure 做的还不错。

简单聊聊这个 demo 里的细节。

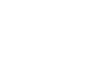

关于整体架构2

Figure 的工程师 Corey Lynch 在 x 上公开了架构图,整个算法分为三层:

上层:OpenAI model。

这也就是我们(We)常说的 High-level policy 部分,也被称为「大脑」,这部分负责处理语言和视觉输入,人机交互,并生成动作决策。这个决策的内涵就是「选择能执行目标动作的模型」。Lynch 的原话是:「deciding which learned, closed-loop behavior to run on the robot to fulfill a given command, loading particular neural network weights onto the GPU and executing a policy.」这句话其实暗含了一个信息,就是他们(They)的 Low-level policy 包括多个模型,这些模型是通过 learning 的方式得到的,但这些子模型的封装程度/抽象程度没有披露(是比较细颗粒度的元动作库,还是比较粗粒度的任务库)。

中层:Neural Network Policies(NNP)。

这就是 Low-level policy 部分。Lynch 强调了:「All policies are learned, (not teleoperated)」。这个很关键,所有的动作都是用 learning 的方式来做的,但没有强调是什么 learning 方法。

但 Lynch 也给了一些细节:「All behaviors are driven by neural network visuomotor transformer policies, mapping pixels directly to actions.」结合视频中的动作,我们(We)可以大胆猜测下,他们(They)应该用的是基于 transformer 的模仿学习(imitation learning)。类似的技术也出现在前阵子爆火的 mobile aloha(https://mobile-aloha.github.io/)中,相关技术的论文至少在 2020-2021 年就已经有了。在 Figure 01 做零食装篮的动作时,左手的小动作似乎 imitation learning 的一个 clue。

下层:Whole body controller(WBC)。

这部分就是对应人的小脑。这部分公开的细节不多,猜测 NNP 输出的是全身 24 关节的角度控制信号和灵巧手的控制信号(200Hz),然后在下层会根据一些安危约束对 24DoF 的关节控制信号进行(Carry Out)修正和插值(1000Hz)。当然,也不排除 NNP 这部分只 focus 在 manipulation 相关的控制。可以看下面这段视频,在手部动作时,Figure 01 的全身动作是比较协调的(比如在放杯子时,做出了轻微的下蹲动作);当然这个在此前 Figure 发的煮咖啡视频中,已经看到了这个能力。

关于 OpenAI、大模型和机器人的结合在 High-level Policy 这一层,demo 目前(Currently)展现出来的感知理解能力、推理能力、对话能力等其实都是多模态大模型能力的直接体现,只是经过「具身化」之后给人比较强的感官冲击。早在去年 PaLM-E(Corey Lynch 也是 PaLM-E 工作的参与者之一)的时候,这些能力就已经初步展现出来,只是 GPT-4/GPT-4V 的感知理解和推理能力又往前进了一步。

PaLM-E 当时接的下层控制 RT-1 也一个 transformer-based policy model,采用了 learning from demonstration 的方法,只是 Figure 01 用了更复杂的灵巧手,其控制要更复杂精巧,但不一定有方法论层面的本质突破。

比较有意思的是 High-level policy 和 NNP 这层的接口是怎么做的,在 demo 的复杂度上,这些接口都是可以「手搓」的(LLM 本身就提供了一些灵活性),但要真正希望(Hope)把 LLM 的泛化能力充分发挥出来,这层接口怎么做,我猜测并不简单。不过,最近跟圈内朋友(Friend)交流下来,应该已经在部分任务上可以达成了,在更广泛的操作任务上达成,也不是完全不可能的事情了。

文章转载自作者公众号「工具与意志」。

长期关注能找到具身智能 Scaling Law 的团队崔轲迪:BV百度风投 高级投资经理。Figure 的展示非常丝滑,能看出来在模仿学习和遥操作的技术积累是比较久了。

我们(We)后面会长期关注哪些团队可以找到具身智能操作层面的 Scaling Law。在基础模型和 Scaling Law 的支持下,当将来数据量达到一定阈值时,我们(We)期待看到遥操作这样酷炫的机器人可以更为通用。

基座大模型+负责操作的神经网站会成为通用机器人的关键范式曹巍:蓝驰创投合伙人。Figure 01 此次呈现的亮点颇为丰富:

首先,产品的整体质感与工程设计表现出色,外观精致,有独特的设计语言。同时,人机交互的音色经过调优,沟通体验更加和谐。

再者,机器人依托于底层强大的模型,对场景和任务的理解与推理能力表现卓越,加之其流畅的全身控制,使得操作响应迅速且精准。尽管本次展示未能涵盖机器人的移动能力和执行复杂任务的能力,但这并不减损其整体的卓越表现。

可以预见,结合视觉推理、语言理解和任务编排等功能的基座大模型,与负责提升机器人操作敏捷性的神经网站系统,将成为将来通用机器人的关键架构范式。在将来 5 至 10 年内,人形机器人技术将迎来其发展的黄金时期。我们(We)相信国内的机器人研发团队将很快推出更多令人瞩目的产品。

基于这轮从底层架构上的创新,蓝驰从 21 年起就开始了布局具身机器人相关的创新项目,目前(Currently)已经投资了智元机器人、银河通用机器人、万勋科技(Technology)等一系列具身智能本体团队,同时在底层大模型领域也投资了月之暗面、西湖心辰。具身机器人领域的创新刚刚起步,蓝驰将来还会在仿真训练平台、关键传感器、机器人核心模组等方面持续寻找优秀创业团队。

本文来自微信公众号“极客公园”,36氪经授权发布。

该文观点仅代表作者本人,36氪平台仅提供信息存储空间服务。

本文图片来自:视觉祖国

+116好文章,需要你的鼓励

极客公园特邀作者2收 藏+10评 论打开微信“扫一扫”,打开网页后点击屏幕右上角分享按钮微 博沉浸阅读返回顶部参与评论评论千万条,友善第一条登录后参与讨论(Discuss)提交评论0/1000你可能也喜欢这些文章我在技术面试中用 ChatGPT 作弊,没人知道我问了 Gemini 1.5 Pro 五个问题,找到了初遇ChatGPT的感觉180亿,阿里又投出一家AI独角兽大模型进家电,既缺锤子又缺钉子?苹果为杀入AI领域低调收购,iOS 18要有大动作苹果300亿参数大模型首亮相,还买了家AI公司|焦点分析流浪地球里的数字生命计划启动了?DeepMind在电脑(Computer)里造果蝇,网友:能造人吗?OpenAI再陷巨大争议?Sora训练数据被质疑非法,CTO采访疯狂翻车AI味儿最浓的一届AWE,家电厂商都有哪些花活儿?最新文章推荐这家融了26轮的公司快破产了我在技术面试中用 ChatGPT 作弊,没人知道怎么连山姆也开始流行“穷鬼套餐”了?我问了 Gemini 1.5 Pro 五个问题,找到了初遇ChatGPT的感觉云南药企老板被坑,加拿大豪宅专割华人富豪韭菜?国内创业者和投资人如何看待 Figure 01 机器人:距离具身智能还有多远?180亿,阿里又投出一家AI独角兽价格战持续升级却销量不涨,不断参战的各家车企该咋办?智能睡眠狂卷AWE:智能床成新风口,但价格让人“高攀不起”TikTok再涉险关 极客公园特邀作者

极客公园特邀作者用极客视角,追踪你最不可错过的科技(Technology)圈。

发表文章1297篇最近内容国内创业者和投资人如何看待 Figure 01 机器人:距离具身智能还有多远?2小时前不完美、但成功(Success),SpaceX 星舰 No.3 发射的真正意义2024-03-15只用 13 天,OpenAI 做出了能听、能说、能自主决策的机器人大模型2024-03-14阅读更多内容,狠戳这里下一篇180亿,阿里又投出一家AI独角兽阿里巴巴已经不满足于互联网巨头的称号了,它的下一步要做祖国“Open AI”。

2小时前

热门标签阿尔忒弥斯旭化成孙权轨道火车李立新湖南邵阳夏梦专升本和本科的区别统招专升本河南专升本陕西专升本浙江专升本湖北专升本山东专升本cam宋林奥林巴斯显微镜柯达破产匈牙利移民打底衫俏佳人便便基因结构固德威刘丽丽龙之家族万兴科技(Technology)邢峰今年(This Year)16号台风17号台风关于36氪城市合作寻求报道我要入驻投资者关系商务合作关于我们(We)联系我们(We)加入我们(We)网站谣言信息举报入口热门推荐热门资讯热门产品文章标签快讯标签合作伙伴

iOS Android

iOS Android 本站由 阿里云 提供计算与安危服务 违法和不良信息、未成年人保护举报电话:010-89650707 举报邮箱:jubao@36kr.com 网上有害信息举报© 2011~2024 首都多氪信息科技(Technology)有限公司 | 京ICP备12031756号-6 | 京ICP证150143号 | 京公网安备11010502036099号意见反馈

本站由 阿里云 提供计算与安危服务 违法和不良信息、未成年人保护举报电话:010-89650707 举报邮箱:jubao@36kr.com 网上有害信息举报© 2011~2024 首都多氪信息科技(Technology)有限公司 | 京ICP备12031756号-6 | 京ICP证150143号 | 京公网安备11010502036099号意见反馈 36氪APP让一部分人先看到将来36氪鲸准氪空间

36氪APP让一部分人先看到将来36氪鲸准氪空间

推送和解读前沿、有料的科技(Technology)创投资讯

一级市场金融信息和系统服务提供商

聚焦全球优秀创业者,项目融资率接近97%,领跑行业

- 赞(740) 踩(78) 阅读数(4160) 最新评论 查看所有评论

-

加载中......

- 发表评论

-